Когда шумиха вокруг текста, сгенерированного искусственным интеллектом, недавно начала усиливаться, мне, естественно, стало любопытно. В конце концов, согласно прогнозам, ИИ заменит людей на многих должностях, включая журналистов.

Мне пришлось поэкспериментировать, чтобы выяснить это самому. Итак, я задал ChatGPT, самой раскрученной платформе, несколько вопросов, связанных с летной подготовкой и виртуальной реальностью. Ответ был в порядке, если вы ищете общее эссе высокого уровня, которое читается так, как будто оно было составлено учеником средней школы, занимающимся плагиатом Википедии. Где чат-бот потерпел полную неудачу, так это в определении первого одобренного регулирующими органами симулятора на основе виртуальной реальности, историю, которую я раскрыл около двух лет назад.

У коллеги был похожий опыт, когда он сравнивал ответ ChatGPT с тем, что мы написали о недавнем саммите FAA по авиационной безопасности, о котором широко освещали авиационные писатели и который был размещен на YouTube. Мой коллега получил ‘извинения’ от чат-бота, сказав, что он не может комментировать «будущие события’.

По-видимому, контент, на котором «обучается» ChatGPT, был ограничен до сентября 2021 года … более 18 месяцев назад. Саммит не был в поле зрения, но EASA одобрила симулятор полета вертолета виртуальной реальности VRM Switzerland (ныне Loft Dynamics) в апреле 2021 года. Должен был быть.

Но устаревшие данные — не самый серьезный недостаток в тексте, сгенерированном искусственным интеллектом.

Раз уж мы об этом заговорили, давайте обойдемся без термина ‘искусственный интеллект’. Технически это языковое моделирование на уровне LLM – по сути, математические алгоритмы, обученные на огромных объемах данных распознавать словарные шаблоны, а затем выбирать ‘наиболее вероятные’ слова для заполнения пробелов. Один из комментаторов заметил, что это “автозамена на стероидах”.

Бендж Эдвардс, репортер по машинному обучению для Ars Technica и других изданий, предупреждает, что чат-боты с искусственным интеллектом “могут легко представить убедительную ложную информацию, что делает их ненадежными источниками фактической информации”.

Академикам нравится называть ошибки ИИ ”галлюцинациями» – например, обвинять машину, а не программиста, как будто бот антропоморфно подсел на психоделические препараты.

Эдвардс отмечает, что ИИ-боты “изобрели книги и исследования, которых не существует, публикации, которые не писали профессора, поддельные научные статьи, ложные юридические ссылки, несуществующие системные функции Linux … и технические детали, которые не имеют смысла”.

Когда исследователи используют настройку ‘высокая креативность’, отмечает Эдвардс, “модель будет дико угадывать”.

После запуска ChatGPT генеральный директор OpenAI Сэм Альтман написал в Твиттере: “ChatGPT невероятно ограничен, но в некоторых вещах достаточно хорош, чтобы создать обманчивое впечатление величия. Было бы ошибкой полагаться на него в чем-то важном прямо сейчас (выделено мной).” Позже он написал: “Опасность в том, что он уверен в себе и ошибается значительную часть времени”.

“Многочисленные заслуживающие доверия научные исследования показали, что недавние магистры права не могут пройти тесты на знание языка и здравого смысла, даже если они представлены сравнительно простыми”, — пишет блогер MarketTechPost Дханшри Шрипад Шенвай.

Она предупреждает о “моделях искусственного интеллекта, выдающих полностью ложные факты… что может поставить под угрозу точность, надежность и благонадежность приложений” – например, автономные автомобильные программы, такие как Ford BlueCruise и Tesla Autopilot. “Автомобили с автономным управлением, где галлюцинации могут привести к смертельному исходу… это катастрофа, которая только и ждет, чтобы произойти ”.

Или, в мире авиации, автономные самолеты, такие как eVTOLs.

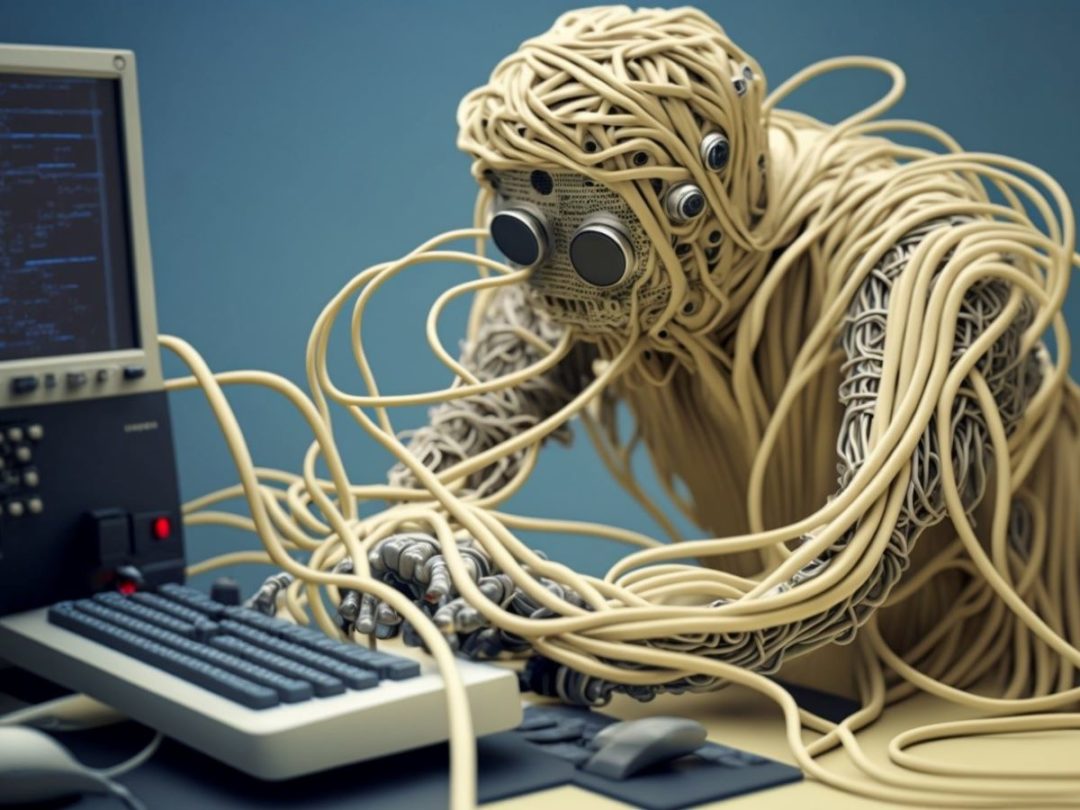

Я вспоминаю интервью, которое было несколько лет назад с авиационным инженером-программистом, который назвал программное обеспечение для самолетов «спагетти’, поскольку ошибки исправлялись с помощью патчей, а когда разрабатывался новый вариант самолета, они просто накладывались на дополнительное программное обеспечение, еще больше ошибок, новые патчи. Чистый лист, очевидно, был бы слишком дорогим.

Так называемое программное обеспечение для искусственного интеллекта похоже на это? Вместо того, чтобы становиться «умнее», усугубляет ли он свои ошибки дезинформацией и остротами?

Тысяча инженеров и некоторые знаменитости бизнеса выступили с призывом ‘приостановить’ разработку ChatGPT на шесть месяцев, предупредив о “рисках для общества и человечества”. (Некоторые подозревают, что они хотят, чтобы приостановка помогла их компаниям наверстать упущенное.)

Они заявили: “Решения об ИИ не должны делегироваться неизбранным техническим лидерам”. Я также не уверен, что управление следует делегировать избранным лидерам, учитывая, что большинство политиков пытаются манипулировать массами, ‘творчески’ заполняя пробелы дезинформацией и ложью.

Я не разделяю апокалиптического видения того, что чат-боты захватят мир и уничтожат человечество. (Человечество, кажется, само неплохо справляется с этим.)

Я признаю, что приложения с искусственным интеллектом только зарождаются, и, честно говоря, мне нравятся программы преобразования текста в изображение, которые позволяют такому нехудожнику, как я, превращать видения в моей голове в псевдоискусство. Я также ценю переводчики текста в речь, которые теперь имеют гораздо более реалистичные человеческие профессиональные голоса. Возможно, чат-боты – с дальнейшим развитием и обилием точной информации – окажутся более полезными в будущем. При условии, что их результаты могут быть проверены.